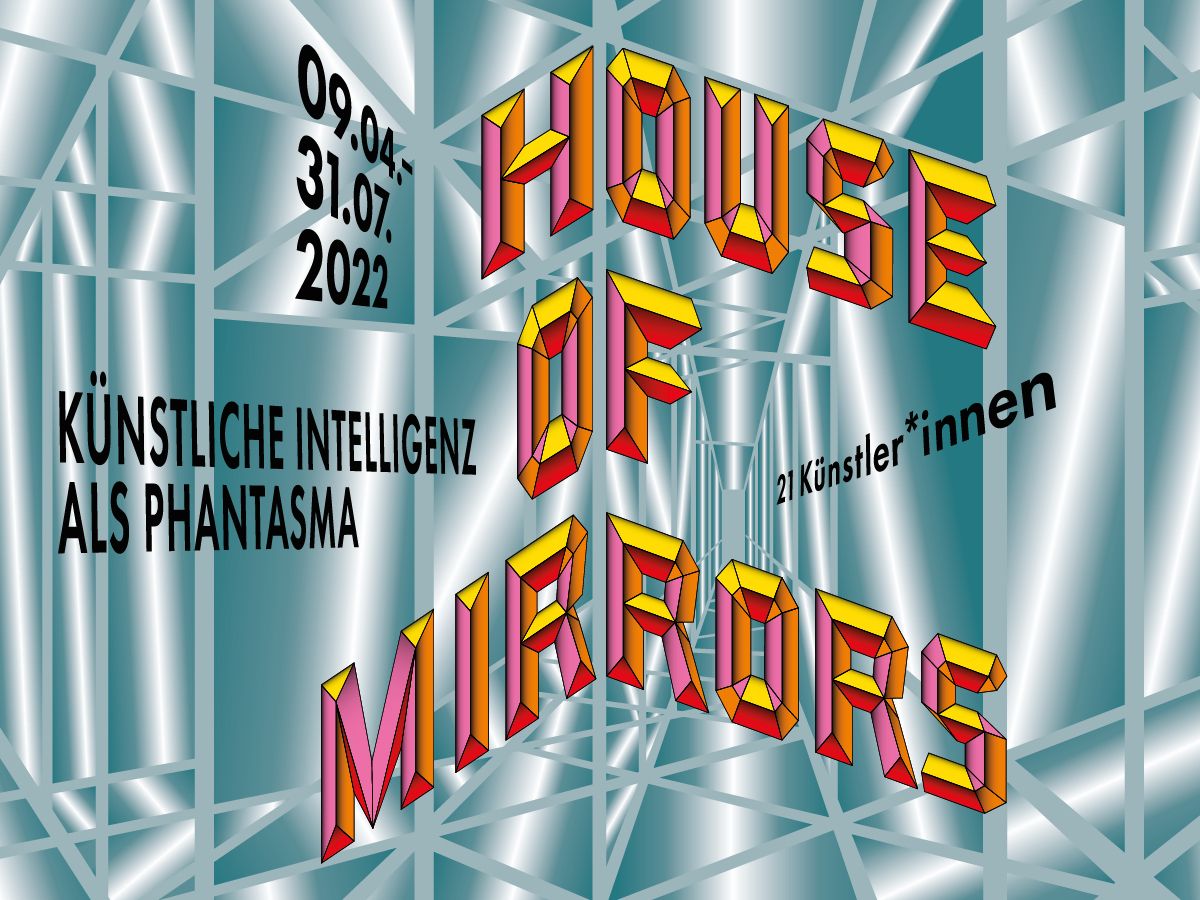

Inke Arns, Dr. phil ist freie Kuratorin und Autorin, seit 2005 künstlerische Leiterin und seit 2017 Direktorin des HMKV Hartware MedienKunstVerein, Dortmund. Im Interview erzählt sie von der Ausstellung "House of Mirrors" und was Spiegelkabinette mit künstlicher Intelligenz zu tun haben. Die Ausstellung ist vom 9. April bis 31. Juli 2022 im HMKV zu sehen.

© VG Bild-Kunst

© VG Bild-Kunst

Akteure im Interview

Künstliche Intelligenz als Phantasma

Die Kunstwelt beschäftigt sich zur Zeit sehr viel mit dem Thema KI, weshalb gerade jetzt?

Künstliche Intelligenz ist halt in unserem Alltag angekommen – man denke nur an Staubsaugerroboter, Gesichtserkennung auf Handys oder autonome Fahrzeuge. Daher setzten sich auch viele Künstler*innen mit KI auseinander. Der HMKV hat schon 2015 eine erste Ausstellung zu dem Thema gemacht und wir hatten jetzt fast die Sorge, zu spät dran zu sein. Aktueller Anlass ist das Forschungsprojekt „Training the Archive“, welches der HMKV Hartware MedienKunstVerein seit 2020 zusammen mit dem Ludwig Forum Aachen durchführt.

Kritische Analysen von KI haben erst in den letzten Jahren an Fahrt aufgenommen – hier denke ich insbesondere an die Veröffentlichungen von Safiya Umoja Nobles Algorithms of Oppression (2018), Pattern Discrimination (2019, hrsg. v. Clemens Apprich, Wendy Hui Kyong Chun, Florian Cramer und Hito Steyerl), das Projekt Excavating AI (2019) von Kate Crawford und dem Künstler Trevor Paglen sowie Kate Crawfords Atlas of AI (2021).

Warum erinnert die Szenografie der Ausstellung an ein riesiges Spiegellabyrinth?

Wir – Marie Lechner, Francis Hunger und ich – ziehen es vor, nicht von „Künstlicher Intelligenz“, sondern von „Mustererkennung“ zu sprechen. Denn es geht um nichts anderes. KI kann nur die Muster erkennen, die wir ihr zuvor antrainiert haben. Je nachdem, mit welchen Daten diese KIs trainiert werden, sind ihre Outputs mehr oder weniger parteiisch, vor(urteils)belastet oder auch rassistisch. Das liegt daran, dass die KI nur so gut (oder schlecht) sein kann, wie die Menschen, die sie trainieren.

Wenn das Ausgangsmaterial (z.B. Bilder von Gesichtern) bereits einer starken Selektion unterworfen ist (z.B. nur Gesichter von Weißen), wird das von der KI gelieferte Ergebnis stark verzerrt sein. Wenn man der KI anschließend Bilder von Menschen mit einer anderen Hautfarbe zeigt, erkennt sie nicht, dass es sich dabei um Menschen handelt, oder aber sie stuft sie als „Gorillas“ oder „Kriminelle“ ein.

Es gibt dazu ein populäres Internet-Meme aus dem Juni 2021, das ich Ihnen hier nicht vorenthalten möchte:

KI kann also stark vorurteilsbelastet („biased“) sein. Sie reflektiert nur das, was wir ihr im Trainingsprozess „beigebracht“ haben. Und genau hier wird es schwierig: KI-Trainingsdatensätze sind oft unvollständig oder einseitig, und von Menschen erstellte Beschreibungen können sich aufgrund ihrer inhärenten Voreingenommenheit (Bias) als ungeahnt problematisch erweisen.

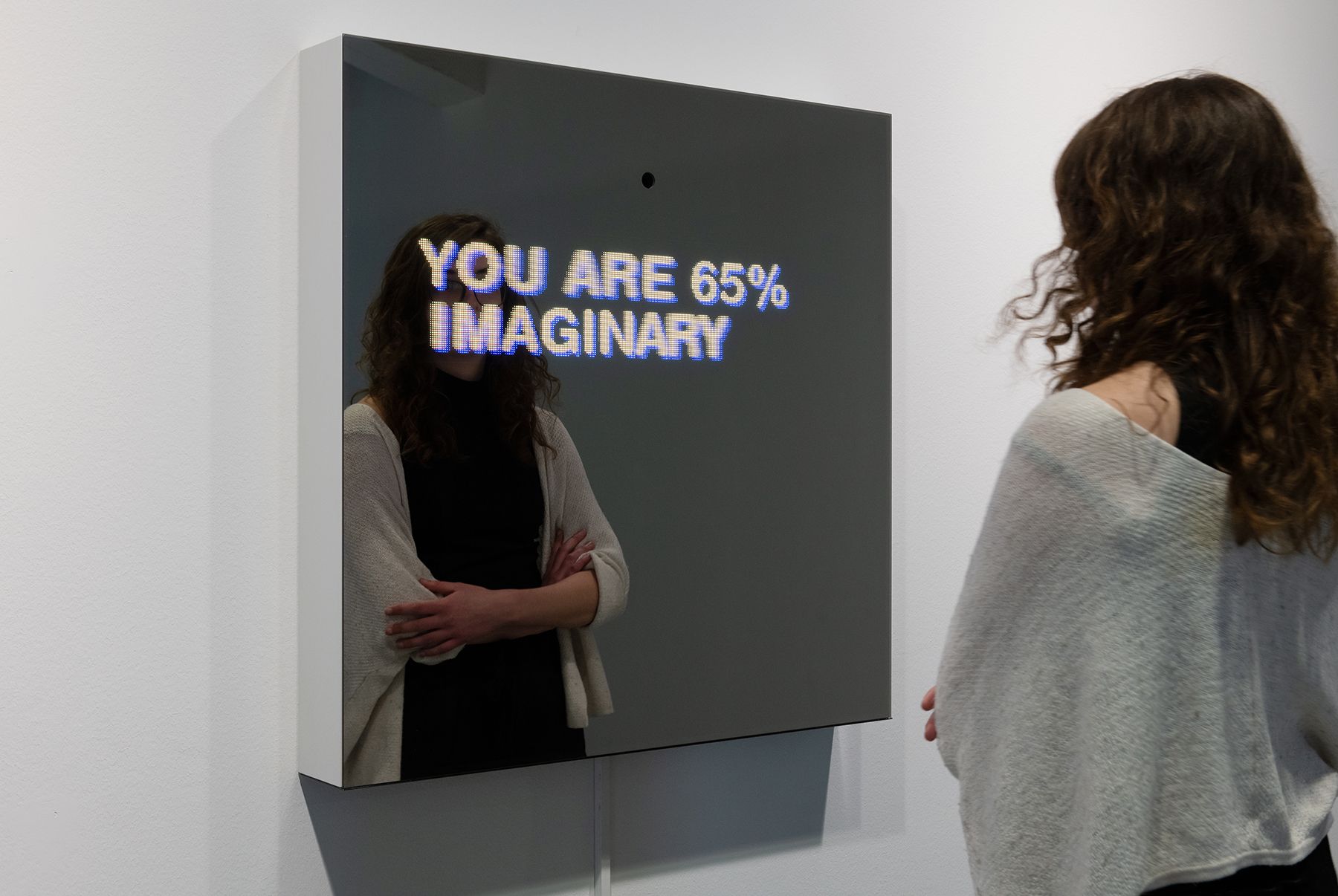

Daher kamen wir auf die Metapher des Spiegellabyrinths (engl. „House of Mirrors“). Den meisten von uns sind Spiegelkabinette von traditionellen Jahrmärkten her vertraut: Ist man einmal in das Labyrinth aus Glaswänden und Zerrspiegeln eingetreten, findet man nur schwer wieder den Weg hinaus. Und alle Reflektionen zeigen nur das eigene Bild, den eigenen Input.

Was sind die sieben thematischen Kapitel der Ausstellung?

Man tritt durch die Lobby ein (hier begrüßen uns schon zwei Arbeiten von Lauren Huret und Sebastian Schmieg) – und dann schließen sich folgenden sieben Räume an:

RAUM 1 - Eine Traumlandschaft der Vollautomatisierung / A Dreamscape of Full Automation

RAUM 2 - Ceci n‘est pas une pipe

RAUM 3 - Eine Wunderkammer mit leicht gewalttätigen Maschinen

RAUM 4 - Die verborgene Kammer der Künstlichen Künstlichen Intelligenz

RAUM 5 - Kabinett des schaurigen Gelächters

RAUM 6 - Erst zerkratzte ich den Spiegel, dann zerschlug ich ihn

RAUM 7 - Exit Through the Gift Shop

Welche Aspekte faszinieren Sie in den ausgesuchten, künstlerischen Arbeiten?

Zur Auswahl kann ich - auch im Namen meiner Kolleg*innen - sagen, dass wir einerseits nach Arbeiten gesucht haben, die gut im Raum funktionieren und nach solchen, die KI nicht nur als Technik verstehen, sondern als gesellschaftliche Konstellation.

Uns fasziniert die Ernsthaftigkeit, mit der Künstler*innen an die Themen herangehen und wie sie versuchen, die Technologie auseinanderzunehmen und zu dekonstruieren. Wie sie Prozesse sichtbar machen, die normalerweise unsichtbar bleiben (wie z.B. die Vorbereitung von Trainings-Daten für KI). Und wie sie, jenseits der Sichtbarmachung, auch exemplarisch Eingreifen und uns zeigen, wie wir Handlungsmacht wiedergewinnen können (so z.B. Jake Elwes‘ The Zizi Show – hier geht es quasi um ein „Queeren“ von Trainingsdaten – oder in Lauren Lee McCarthys LAUREN, in der die Künstlerin die Rolle eines digitalen Assistenten in einem Smart Home übernimmt).

Warum widmet sich die Ausstellung insbesondere den problematischen Aspekten von KI?

Weil diese viel zu wenig adressiert werden. KI ist in der Vorstellung der meisten – natürlich auch der Industrie – ein reines Lösungstool, das quasi objektive Entscheidungen trifft. Wir wollen zeigen, dass KI alles andere als objektiv ist.

Automatisierung hat eine tatsächliche Wirkungsmacht, denn sie wirkt sich auf unser aller Leben aus. KI ist die nächste Stufe der Automatisierung, mit der wir uns auseinandersetzen müssen. Charlie Chaplin hat das in seinem Filmklassiker Modern Times für das 20. Jahrhundert gemacht. Jetzt leben wir im 21. Jahrhundert.

Welchen gesellschaftlichen Umgang mit KI würden Sie sich wünschen?

Es geht um Transparenz, um das Öffnen der Black Box der Künstlichen Intelligenz. Wir müssen wissen, was in dieser Black Box passiert. Wir müssen die Mechanismen verstehen, auf deren Grundlage wir eingeordnet, kategorisiert und bewertet werden. Das erreichen wir nicht nur mit der Vermittlung von mehr Medienkompetenz in der Schule, sondern auch durch das Verstehen von Mustererkennung und KI-getriebenen Entscheidungen in unserem Alltag, überall und jederzeit.

Key Visual der Ausstellung "House of Mirrors: Künstliche Intelligenz als Phantasma"

Sebastian Schmieg, "Decisive Mirror“, 2019, Foto: Franz Wamhof

Mushon Zer-Aviv, "Normalizi.ng”, 2021

Adam Harvey, "Today's selfie is tomorrow's biometric profile", 2021.

Simone C Niquille/Technoflesh, "Sorting Song", 2021. 06:50